View in Telegram

#llm #blog

Трендовые статьи по Large Language Model

Пост в блоге

Краткое содержания блогпоста:

- самокоррекция в LLM через обучение с подкреплением: Google Deepmind предложили инновационный подход для повышения способности больших языковых моделей (LLM) к самокоррекции.

- квантование LLM для выполнения инструкций: Было установлено, что методы квантования существенно влияют на производительность LLM. Ключевое наблюдение – квантование моделей с большими параметрами (405B) часто дает лучшие результаты.

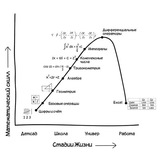

- память в LLM: Было доказано, что LLM обладают памятью, а архитектура Transformer выполняет функцию аппроксимации входных данных, демонстрируя «память Шрёдингера», которая активируется входными данными.

- Logic-of-Thought для улучшения рассуждений LLM: Новый подход Logic-of-Thought (LoT) показал значительное улучшение производительности LLM на задачах логического рассуждения, в частности, на наборах данных ReClor, LogiQA и ProofWriter.

Пост в блоге

Love Center - Dating, Friends & Matches, NY, LA, Dubai, Global

Find friends or serious relationships easily