View in Telegram

#llm

Галлюцинации LLM

Вы слышали про галлюцинации у LLM моделей?

Очень много работ и техник пытаются решить эту проблему

Но вот совсем недавно вышла статья утверждающая, что структурные галлюцинации никогда не могут быть устранены из LLM. И это независимо от модели, RAG, или мер защиты/постобработки.

Термин структурные галлюцинации вводится именно в этой статье.

Авторы проводят анализ опираясь на теорию вычислений и первую теорему Гёделя о неполноте, которая касается неразрешимости задач, таких как задачи остановки, пустоты и принятия.

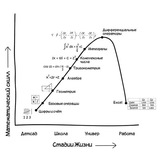

Авторы утверждают, что на всех этапах процесса работы LLM — от составления обучающих данных до поиска фактов, классификации намерений и генерации текста — существует ненулевая вероятность появления галлюцинаций.

Действительно ли от галлюцинаций у LLM моделей не возможно избавиться? Как вы думаете?

arXiv.org

LLMs Will Always Hallucinate, and We Need to Live With This

As Large Language Models become more ubiquitous across domains, it becomes important to examine their inherent limitations critically. This work argues that hallucinations in language models are...

Love Center - Dating, Friends & Matches, NY, LA, Dubai, Global

Find friends or serious relationships easily