View in Telegram

#llm

RAG и Long-Context LLMs

В ранних версиях LLM модели с RAG были надежным решением для создания ответов на основе контекста.

С появлением long-context LLM, которые могут работать с гораздо более длинными текстами, RAG стал менее популярным, так как новые модели часто превосходят его в задачах с большим контекстом.

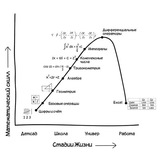

В новой статье от NVIDIA сообщается, что при слишком длинном контексте LLM теряют фокус на важной информации, что снижает качество ответов. В статье предлагается новый механизм, называемый OP-RAG (Order-Preserve Retrieval-Augmented Generation), который улучшает работу RAG за счёт сохранения порядка полученных фрагментов данных, что помогает достичь более высокого качества ответов.

Эксперименты на публичных бенчмарках (например, En.QA dataset) показали, что OP-RAG может превзойти современные длинноконтекстные модели без использования RAG, демонстрируя лучшую точность и качество ответов.

Ссылка на статью

Love Center - Dating, Friends & Matches, NY, LA, Dubai, Global

Find friends or serious relationships easily