View in Telegram

Книга "Информация" 2011 г. Д.Глика - как Клод Шеннон связал инфо и неопределенность (энтропию). Инфо - это [отрицательная] энтропия, неопределенность, неожиданность, редкость, трудность расчета

1. Письмо

- Алфавит появился лишь однажды 1500 лет до н.э. у Палестины - 22 буквы. В мире 6000 устных языков, без букв. Пиктографические языки 30 тыс лет назад (с палеолита)

- В Африке барабанами передавали звуки, еще не буквы, но уже не слова. А Морзе взял уже не звуки, а части слов - буквы (телеграф работал с азбукой Морзе)

- Письменность была нужна, чтобы сохранить инфо во времени и пространстве. До письма коммуникация была недолговечной и локальной. Канал письма не просто расширил предыдущие, он дал появиться методам повторного использования и воспоминания

- В Ср.Азии изучали аборигенов, те не принимали логические силлогизмы. Типа: «На Севере, где всегда снег, все медведи белые. Новая Земля - на Севере, и там всегда снег. Какого цвета медведи?» Типичный ответ: «Не знаю. Я видел бурого, а других нет, в каждой местности свои животные». А человек, только умеющий читать и писать, отвечал: «Исходя из ваших слов они должны быть белыми». «исходя из ваших слов» = переход на другой уровень = инфо отделяется от личности, от опыта говорящего

- Письмо вызывало волнения, маршалл Маклюэн говорил, что печать дает узкий канал, линейный, фрагментарный. А в речи, в разговоре лицом к лицу с жестами и касаниями, важны все чувства

- Первый словарь английского сделал школьный учитель в 1604. Оксфордский словарь 1928г был 400К слов + неск. тыс. слов ежегодно

2. Математика

- Она вышла из письма - системного подхода к записи чисел. Логарифмы открыл Непер... Натуральные числа. Он пришел интуитивно, с терминами “разница” и “отношение”

- Буль придумал логику, операции, матлогику

3. Беббидж и его вычислитель

- Поступил в Тринити-колледж в 1810 и понял, что знает больше преподов, стал читать зарубежные книги. В 1820 сделал механическую разностную машину

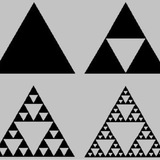

- Ада Лавлейз работала с ним и стала первой кодершей. Она придумала процесс, набор правил, цепь операций, потом это назвали бы алгоритмом, позже - программой, но тогда концепция требовала мучительных объяснений. Причем ее алгоритм оказался рекурсивным и исполнялся циклически: результат одной итерации становился данными для следующей

- Машину Беббиджа финансировали 20 лет госведомства, военные итп

4. Шеннон

- bit = binary digit

- До Шеннона в Bell Labs Хартли сформулировал: Н = n*logS, где Н - количество инфо, n - число символов в сообщении, S - число символов в языке

- В MIT делали дифференциальный анализатор Буша

- Шеннон работал в электро лабе и понял, что инфо передается даже в самом факте замкнута цепь или нет

- Шеннон: неопределенность можно измерить, сосчитав количество возможных сообщений. Если возможно лишь одно сообщение, неопределенности нет и, значит, там нет инфо. "Некоторые сообщения могут быть более вероятными, чем другие, и инфо подразумевает неожиданность", это есть способ выражать вероятности. Если буква, следующая за t (в английском языке), h, то передается не так много инфо, тк вероятность h после t сравнительно высока

- "Имеет существенное значение трудность передачи сообщения из одной точки в другую". Это, наверное, покажется столь же тавтологичным, как определение массы в терминах силы, нужной, чтобы сдвинуть объект. Но, с др.стороны, массу таким образом определить можно

- Каждый инженер [в электролабах тех времен], если просили передать больше инфо по каналу, знал - надо выше мощность сигнала. Но на больших расстояниях подход не работал, тк усиление [аналогового] сигнала всегда вело к росту шума. Шеннон обошел это, увидев сигнал как цепь дискретных символов. И вместо роста мощности отправитель мог преодолеть шум, _используя лишние символы_ для коррекции ошибок, ровно как африканский барабанщик не стучал сильнее, а растил число слов в послании (!)

- "Информация есть энтропия". Это было самым странным и самым мощным определением. Энтропия есть мера неупорядоченности системы в термодинамике

// Часть 2 тут

Love Center - Dating, Friends & Matches, NY, LA, Dubai, Global

Find friends or serious relationships easily